AI大模型原理和应用面试题(二)

1. 什么是 LangChain Agent?

LangChain Agent 是 LangChain 框架中用于实现 “动态决策与工具调用” 的核心组件,它能让大模型根据用户需求自主判断 “是否需要调用工具、调用哪些工具、执行顺序如何”,而非按固定流程执行任务。核心特点是 “自主性”—— 通过大模型的推理能力分析任务,生成行动步骤,执行后根据结果调整策略,直至完成目标。例如:用户查询 “分析 2024 年 Q2 新能源汽车销量同比增长原因”,Agent 会先调用 “数据检索工具” 获取销量数据,再调用 “数据分析工具” 计算增长率,最后结合检索到的政策文档,生成结构化分析结果。核心组成:① 决策器(大模型):负责任务分析与步骤规划;② 工具集(如检索工具、API 调用工具、代码执行工具):执行具体操作;③ 记忆模块:存储任务执行过程中的中间结果,辅助后续决策。

2. 什么是 LangChain model?

LangChain model 是 LangChain 框架中 “对接与管理大模型” 的核心模块,并非独立模型,而是一套标准化的模型交互接口与封装工具,支持整合各类大模型(闭源 / 开源、文本 / 多模态),并提供统一的调用方式,降低多模型适配成本。核心功能:① 模型适配:支持对接 OpenAI GPT、Google Gemini、Anthropic Claude、开源 Llama 系列等,封装不同模型的 API 差异,提供统一的 LLM/ChatModel 类;② 参数控制:统一配置模型生成参数(如 temperature 控制随机性、max_tokens 控制输出长度);③ 输出处理:结合 OutputParser 将模型输出转为结构化格式(如 JSON、列表);④ 缓存与重试:集成模型调用缓存(如 GPTCache)、失败自动重试机制,提升稳定性。例如:通过 OpenAI 类调用 GPT-4,通过 HuggingFacePipeline 类调用本地部署的 Llama 3,均使用 invoke() 方法触发生成,接口逻辑一致。

3.LlamaIndex 如何与 LangChain 结合?

LlamaIndex(原 GPT Index)是专注于 “知识检索与管理” 的框架,LangChain 是专注于 “流程编排与工具集成” 的框架,二者结合可互补优势,构建更强大的 RAG 或智能体应用,常见结合方式有 3 种:

LlamaIndex 作为 LangChain 的检索组件:LangChain 通过 LlamaIndexRetriever 接口调用 LlamaIndex 的检索能力(如 LlamaIndex 的向量检索、结构化数据检索),将检索结果传入 LangChain 的 RetrievalQA 链,结合大模型生成回答。例如:用 LlamaIndex 处理复杂文档(如多模态 PDF)并构建检索索引,LangChain 负责整体流程(检索→提示组装→生成)。

LangChain 作为 LlamaIndex 的工具扩展:LlamaIndex 的智能体(如 QueryEngine)通过 LangChainTool 调用 LangChain 集成的工具(如 API 调用、代码执行),扩展 LlamaIndex 的功能边界。例如:LlamaIndex 检索到数据后,调用 LangChain 的 PythonREPLTool 执行数据分析代码。

共享模型与记忆模块:二者可共享同一大模型(如均使用 GPT-4)和记忆模块(如 LangChain 的 ConversationBufferMemory 与 LlamaIndex 的 ChatMemoryBuffer 互通),确保对话逻辑连贯,避免重复数据处理。

4. 什么是 LangGraph ?

LangGraph 是 LangChain 团队推出的用于 “构建状态化、循环式工作流” 的框架,基于 “有向图(Directed Graph)” 结构设计,核心目标是解决 LangChain 基础链(如 SequentialChain)“线性流程、无状态” 的局限,支持复杂任务的动态循环与分支决策。核心特点:① 状态化:通过 “状态(State)” 存储任务执行过程中的中间数据(如用户查询、检索结果、工具输出),后续步骤可读取并更新状态;② 循环与分支:支持流程分支(如 “检索结果相关则生成回答,不相关则重新检索”)、循环(如 “多轮工具调用直至获取有效结果”);③ 可视化:支持用 Mermaid 生成工作流图表,便于调试与理解。适用场景:多轮对话智能体、复杂业务流程(如电商售后工单处理:“接收工单→判断类型→调用对应工具→生成解决方案→用户确认→闭环”)、多智能体协作。

5.LangGraph 编排的原理是什么?

LangGraph 基于 “有向图 + 状态管理” 实现流程编排,核心原理分 4 步:

定义状态结构(State):通过 TypedDict 或自定义类定义流程中的核心数据字段(如 user_query 存储用户查询、retrieved_docs 存储检索结果、agent_response 存储生成回答),状态在流程中可被读取和更新。

定义节点(Nodes):每个节点对应一个具体操作(如 “检索节点” 调用检索工具、“生成节点” 调用大模型、“判断节点” 决定流程分支),节点函数接收当前状态,执行操作后返回更新后的状态。

定义边(Edges):通过边连接节点,指定流程走向 ——① 固定边:从节点 A 固定指向节点 B(如 “检索节点→生成节点”);② 条件边:根据状态中的数据动态决定走向(如 “判断节点” 检查 retrieved_docs 是否为空,为空则指向 “重新检索节点”,非空则指向 “生成节点”)。

执行与状态流转:启动流程时传入初始状态(如仅含 user_query),LangGraph 按节点顺序执行,每次执行节点后更新状态,再根据边的规则决定下一个节点,直至触发 “结束节点” 或满足终止条件(如生成回答完成)。

6.LangChain 和 LangGraph 有什么区别?

7. 什么是 Manus?说说你对它的了解

Manus 是字节跳动推出的 “大模型训练与推理一体化平台”,核心定位是为企业和开发者提供 “从数据处理、模型训练、微调优化到部署推理” 的全链路工具链,降低大模型应用开发的技术门槛,尤其聚焦于 “高效训练” 与 “低成本推理”。核心功能:① 数据治理:提供数据清洗、标注、格式转换工具,支持文本、图片、音频等多模态数据处理,适配大模型训练数据需求;② 模型训练与微调:支持主流开源模型(如 Llama、Qwen)的预训练与微调,提供分布式训练框架,优化 GPU 资源利用率,降低训练成本;③ 推理部署:支持模型压缩(如量化、剪枝)、推理加速(如 TensorRT 优化),提供多实例部署、负载均衡能力,适配高并发场景;④ 监控与运维:提供模型性能监控(如推理延迟、准确率)、资源使用率监控,支持模型版本管理与回滚。适用场景:企业级大模型定制(如训练行业专属模型)、大模型应用落地(如将微调后的模型部署为 API 服务),目前主要面向字节跳动生态内企业及合作方。

8.Computer Use 是什么?说说它的原理

Computer Use(计算机使用能力)是指大模型通过调用 “操作系统工具、软件应用、代码执行环境”,模拟人类操作计算机完成任务的能力,核心是让大模型从 “文本生成” 扩展到 “实际操作执行”,例如自动编写 Excel 公式、生成代码并运行、操作浏览器获取网页数据。原理:① 工具封装:将计算机操作(如文件读写、代码执行、浏览器控制)封装为标准化工具(如 LangChain 的 PythonREPLTool、SeleniumTool),定义输入输出格式;② 任务分析:大模型接收用户需求(如 “用 Python 分析 2024 年销量数据并生成折线图”),拆解为具体操作步骤(如 “读取 CSV 文件→计算增长率→调用 Matplotlib 绘图→保存图片”);③ 工具调用:大模型按步骤调用对应工具,传入参数(如文件路径、代码片段),获取工具执行结果(如图片保存路径、计算结果);④ 结果整合:大模型将工具执行结果整理为自然语言回答,返回给用户,若执行失败则调整步骤重新调用(如代码报错时修正语法后重试)。

9.ReAct 是什么?说说它的原理

ReAct 是一种 “大模型推理与行动结合” 的框架,核心思想是让大模型通过 “思考(Reasoning)→行动(Action)→观察(Observation)” 的循环,逐步完成任务,强调 “透明化推理过程” 与 “基于反馈调整策略”,避免大模型直接生成结果而隐藏中间逻辑。原理(以 RAG 场景为例):① 思考(Reasoning):大模型接收用户查询(如 “2024 年 Q2 新能源汽车销量冠军是谁”),分析任务需求,判断 “需要检索最新销量数据,现有知识可能过时”,生成思考过程文本(如 “用户需要 2024 年 Q2 销量冠军信息,该数据具有时效性,需调用检索工具获取最新报告”);② 行动(Action):大模型根据思考结果,调用对应工具(如检索工具),传入参数(如 “2024 Q2 新能源汽车销量冠军”);③ 观察(Observation):获取工具执行结果(如检索到 “2024 Q2 比亚迪销量 50 万辆,为冠军”),将结果反馈给大模型;④ 循环或结束:大模型判断结果是否满足需求(如 “已获取明确冠军信息,无需进一步检索”),若满足则生成最终回答,若不满足则重复 “思考→行动→观察” 循环(如结果不明确时调整检索关键词重试)。

10. 在大模型应用中,通常如何实现长短期记忆机制?

大模型应用中的长短期记忆机制通过 “分层记忆模块” 实现,区分 “短期对话记忆” 与 “长期知识记忆”,核心目标是 “保留关键信息,避免冗余,支持多轮连贯交互”,常见实现方式:

短期记忆(Short-Term Memory):① 存储内容:最近 N 轮对话的用户查询与模型回答(如近 5 轮);② 实现方式:用缓存结构(如 LangChain 的 ConversationBufferMemory)存储对话历史,每次生成回答前将历史拼接至提示词,确保大模型理解上下文;③ 优化:通过 ConversationSummaryMemory 对早期对话进行总结(如 “用户此前询问过退款流程,现在追问审核进度”),减少 Token 消耗。

长期记忆(Long-Term Memory):① 存储内容:用户个性化信息(如姓名、偏好、历史业务数据)、长期知识(如企业内部文档、用户历史订单);② 实现方式:将长期信息存入向量数据库(如 Pinecone)或关系型数据库,当用户发起新查询时,通过检索(如根据用户 ID 检索个性化信息)将相关长期记忆提取至当前对话,结合短期记忆生成回答;③ 示例:电商客服智能体,长期记忆存储用户历史购买记录,用户询问 “我的订单何时发货” 时,检索用户 ID 对应的订单数据,结合短期对话生成回答。

记忆融合:生成回答时,先读取短期记忆理解对话上下文,再检索长期记忆补充个性化 / 专业知识,二者融合后生成精准回答,例如 “根据您上次咨询的退款政策(短期记忆),结合您的会员等级(长期记忆),审核周期可缩短至 2 个工作日”。

11.Copilot 模式和 Agent 模式的区别是什么?

12. 什么是向量数据库?在基于大模型的应用开发中,向量数据库主要解决什么问题?

向量数据库是专门用于 “存储、管理、查询高维向量数据” 的数据库,通过优化的索引结构与查询算法,实现对高维向量(如 Embedding 模型生成的文本向量、图片向量)的高效相似性查询,核心是 “快速找到与目标向量语义 / 特征最相似的向量集合”。

在大模型应用中,向量数据库主要解决 3 类核心问题:① 大模型知识局限:大模型训练数据有时间截止点(如 GPT-4 截止到 2023 年),向量数据库存储最新文档(如 2024 年行业报告),通过检索为大模型提供实时知识,避免 “幻觉”;② 高维向量查询效率:大模型生成的向量维度通常为 384-3072 维,传统数据库无法高效处理高维向量相似性查询,向量数据库通过 HNSW、IVF 等索引,将查询时间从秒级降至毫秒级;③ 大规模数据管理:当文档数量达百万 / 千万级时,向量数据库支持水平扩展,存储海量向量数据,同时保障查询性能,满足高并发场景(如客服智能体的实时检索需求)。

13. 你都了解哪些向量数据库?如何选型?

常见向量数据库

闭源 / 云服务型:① Pinecone:云原生向量数据库,支持自动扩缩容,查询延迟低,适合高并发场景;② Weaviate:支持多模态向量(文本、图片、音频),集成大模型 API,适合多模态应用;③ Milvus Cloud:Milvus 的云版本,支持托管服务,简化运维。

开源 / 本地部署型:① Milvus:开源向量数据库,支持多种索引(HNSW、IVF),扩展性强,适合私有化部署;② Chroma:轻量级开源向量数据库,部署简单,适合开发测试、小规模应用;③ FAISS(Facebook AI Similarity Search):轻量级开源库,适合嵌入应用内部,不支持分布式部署,适合小规模数据。

国内厂商型:① 阿里云向量数据库:支持与阿里云生态(如达摩院 Embedding 模型)无缝集成,适合国内企业;② 腾讯云向量数据库:支持高可用部署,对接腾讯云大模型(如混元),适合腾讯生态用户。

选型维度

数据规模:小规模(万级向量)选 Chroma、FAISS;中大规模(百万 - 亿级)选 Milvus、Pinecone;

部署方式:需私有化部署选 Milvus、Chroma;无需运维选 Pinecone、阿里云向量数据库;

功能需求:多模态支持选 Weaviate;高并发低延迟选 Pinecone;成本敏感选开源 Milvus;

生态适配:用阿里云 / 腾讯云大模型选对应厂商向量数据库;用 LangChain/LlamaIndex 选 Milvus、Chroma(生态集成完善)。

14. 向量数据库原理是什么?请简述下它的原理

向量数据库的核心原理围绕 “向量存储、索引构建、相似性查询” 三个环节,核心是通过优化索引结构降低高维向量查询的时间复杂度,具体步骤:

向量存储:将 Embedding 模型生成的高维向量(如 768 维)与对应元数据(如文档片段、来源、时间)存储到数据库,向量以二进制或浮点数组形式存储,元数据用于后续结果筛选(如按时间范围过滤)。

索引构建(核心环节):为解决 “高维向量暴力查询(遍历所有向量计算相似度)效率低” 的问题,通过索引结构对向量进行分组或映射,常见索引类型:① HNSW(分层导航小世界):构建多层 “邻居图”,高层图稀疏、低层图密集,查询时从高层快速定位到低层,大幅减少计算量;② IVF(倒排文件):将向量空间划分为多个聚类,每个聚类对应一个 “倒排桶”,查询时先定位目标向量所属聚类,仅在该聚类内计算相似度;③ PQ(乘积量化):将高维向量拆分为多个低维子向量,对每个子向量量化存储,减少存储空间并加速相似度计算。

相似性查询:用户输入查询向量后,流程为:① 索引检索:通过索引快速筛选出候选向量集合(如 HNSW 定位到相关聚类、IVF 筛选目标桶);② 相似度计算:对候选向量,用余弦相似度、欧几里得距离等算法计算与查询向量的相似度;③ 结果排序与返回:按相似度从高到低排序,取 Top-K 结果,关联元数据返回给用户。

15. 向量数据库中的 HNSW、LSH、PQ 分别是什么意思?

HNSW(Hierarchical Navigable Small Worlds,分层导航小世界):是向量数据库中常用的 “近似最近邻搜索(ANN)索引结构”,核心思想是构建多层 “邻居图”:① 底层图包含所有向量,每个向量关联多个 “近邻向量”;② 高层图是底层图的稀疏子集,向量关联少量 “远距离邻居”;查询时从最高层开始,通过邻居节点快速定位到低层,最终在底层找到与查询向量最相似的向量。优势:查询速度快、准确率高,适合大规模高维向量场景;缺点:索引构建耗时、占用内存较多。

LSH(Locality-Sensitive Hashing,局部敏感哈希):是通过 “哈希函数” 将相似向量映射到同一哈希桶的索引技术,核心特性是 “语义相似的向量有更高概率被哈希到同一桶,不相似向量则概率低”。查询时,先将查询向量哈希到对应桶,仅在该桶内计算向量相似度,减少计算范围。优势:索引构建简单、内存占用低;缺点:准确率依赖哈希函数设计,易出现 “相似向量未哈希到同一桶” 的漏检问题,适合对准确率要求不高、追求速度的场景。

PQ(Product Quantization,乘积量化):是一种 “向量压缩与量化” 技术,核心是将高维向量拆分为多个低维子向量(如 768 维拆分为 8 个 96 维子向量),对每个子向量单独进行量化(如将连续值映射到有限的离散码本),存储时仅保存量化后的码本索引,而非原始向量。查询时,通过码本计算子向量相似度,再合并得到整体相似度。优势:大幅减少存储空间(压缩率可达 10-100 倍)、加速查询;缺点:量化过程会损失部分精度,属于近似查询技术,适合存储资源有限的场景。

16. 向量数据库中的 ANN 是什么?为什么需要用它?

ANN(Approximate Nearest Neighbor,近似最近邻搜索):是向量数据库中用于 “快速查找与目标向量语义相似的向量集合” 的核心技术,与 “精确最近邻搜索(Exact Nearest Neighbor,ENN)” 相对 ——ENN 会遍历所有向量计算相似度,确保找到绝对最相似的向量,但高维、大规模数据下效率极低;ANN 通过牺牲少量精度(通常准确率可达 90% 以上),采用优化的索引结构(如 HNSW、LSH)减少计算量,实现毫秒级查询。

需要用 ANN 的核心原因:① 解决高维向量查询效率问题:高维向量(如 512 维、1024 维)的 “维度灾难” 导致 ENN 遍历查询时间复杂度为 O (N)(N 为向量总数),百万级向量下需秒级甚至分钟级,无法满足实时应用需求;ANN 通过索引将时间复杂度降至 O (logN) 或 O (√N),支持百万 / 千万级向量毫秒级查询;② 平衡性能与成本:ENN 需消耗大量计算资源(CPU/GPU),大规模场景下成本极高;ANN 减少计算量,降低硬件资源消耗,同时满足多数业务对精度的需求(如 RAG 检索只需 Top-K 相似片段,无需绝对精确);③ 适配实时应用场景:大模型应用(如客服智能体、实时推荐)对响应时间要求严格(通常 < 3 秒),ANN 是实现实时检索的关键技术。

17. 向量数据库中,常见的向量搜索方法:余弦相似度、欧几里得距离和曼哈顿距离分别是什么?有什么区别?

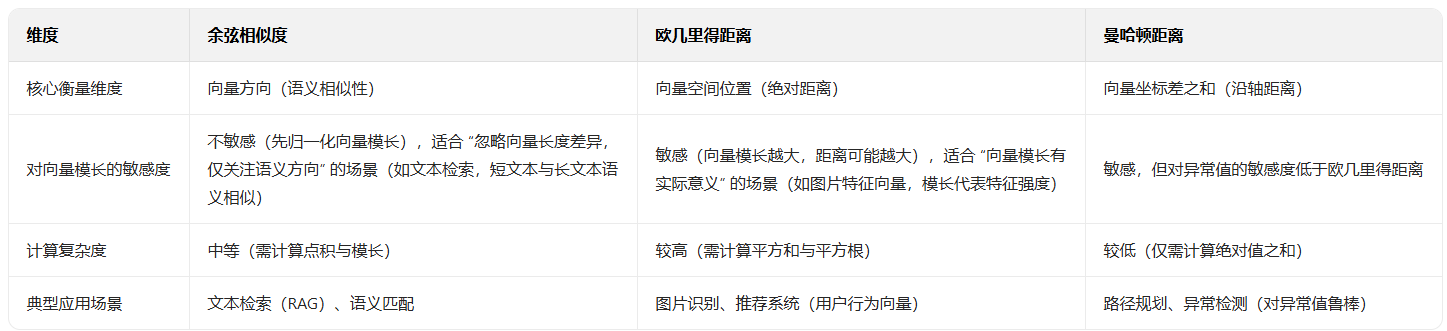

定义

余弦相似度(Cosine Similarity):衡量两个向量 “方向的相似性”,计算两个向量夹角的余弦值,取值范围 [-1, 1]—— 值越接近 1,向量方向越一致(语义越相似);值接近 0,方向无关;值接近 -1,方向相反。公式:cosθ = (A·B) / (||A|| × ||B||)(A・B 为向量点积,||A||、||B|| 为向量模长)。

欧几里得距离(Euclidean Distance):衡量两个向量在 “空间中的直线距离”,取值范围 [0, +∞)—— 值越小,向量在空间中越接近(语义越相似)。公式:d = √[(x₁-y₁)² + (x₂-y₂)² + ... + (xₙ-yₙ)²](x、y 为两个向量的维度值)。

曼哈顿距离(Manhattan Distance):衡量两个向量在 “空间中沿坐标轴的绝对距离之和”,取值范围 [0, +∞)—— 值越小,向量越相似。公式:d = |x₁-y₁| + |x₂-y₂| + ... + |xₙ-yₙ|。

区别

18. 向量数据库的工作流程有哪些?请简述下

向量数据库的工作流程分为 “离线索引构建” 与 “在线查询服务” 两大阶段,共 6 个核心步骤:

数据准备:从外部来源(如本地文档、数据库、API)获取原始数据(文本、图片、音频),通过 Embedding 模型(如 OpenAI text-embedding-3-small、Sentence-BERT)将原始数据转换为高维向量,同时关联元数据(如文本片段、数据来源、时间戳)。

索引构建(离线):将生成的向量与元数据导入向量数据库,选择合适的索引类型(如 HNSW、IVF)构建索引 ——① 数据分片:将向量按规则拆分到不同分片(分布式部署场景);② 向量聚类 / 映射:按索引算法对向量处理(如 HNSW 构建多层邻居图、IVF 划分聚类);③ 索引存储:将索引结构与向量数据持久化到磁盘,确保重启后可复用。

查询向量生成(在线):用户输入查询需求(如文本 “2024 年新能源汽车销量”),通过与离线阶段相同的 Embedding 模型,将查询转换为与文档向量维度一致的查询向量。

近似检索:向量数据库加载索引,对查询向量执行 ANN 搜索 ——① 索引定位:通过索引快速筛选候选向量(如 HNSW 从高层导航到低层、IVF 定位目标聚类);② 候选筛选:从候选向量中初步筛选出数百至数千个潜在相似向量,减少后续计算量。

相似度计算与排序:对候选向量,用余弦相似度、欧几里得距离等算法计算与查询向量的相似度,按相似度从高到低排序,取 Top-K(如 Top 5、Top 10)结果。

结果返回:将排序后的向量关联元数据(如文档片段、来源链接),整理为用户可理解的格式(如 “【来源:2024 年行业报告】2024 年新能源汽车销量达 1200 万辆”),返回给用户或上游应用(如 RAG 大模型)。

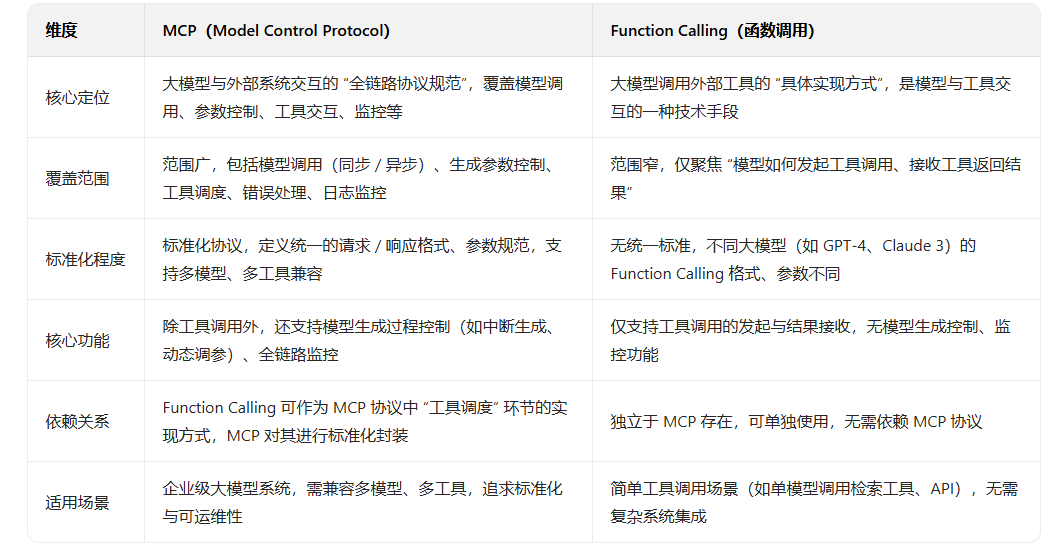

19. 什么是 MCP 协议,它在 AI 大模型系统中的作用是什么?

MCP(Model Control Protocol,模型控制协议):是一套用于 “标准化大模型与外部系统(如工具、服务、客户端)交互” 的协议,定义了大模型的调用方式、参数格式、结果返回、错误处理等规范,核心目标是 “解决不同大模型接口不统一、调用逻辑碎片化” 的问题,实现 “一次集成,多模型兼容”。

在 AI 大模型系统中的作用:① 接口标准化:统一不同大模型的调用接口(如 OpenAI GPT、Google Gemini、开源 Llama),开发者无需为每个模型编写适配代码,只需按 MCP 规范调用,降低集成成本;② 精细化控制:支持对大模型生成过程的精细化控制(如动态调整 temperature、max_tokens,中断生成,设置停止词),满足不同场景的生成需求(如严谨报告生成设 low temperature,创意写作设 high temperature);③ 工具调用规范化:定义大模型调用外部工具的格式(如工具参数、返回结果解析),实现 “模型 - 工具” 交互的标准化,避免因工具接口差异导致的调用失败;④ 可观测性与监控:内置日志记录、性能监控字段(如调用耗时、Token 消耗、错误码),便于系统监控大模型调用状态,快速定位问题。

20.MCP 架构包含哪些核心组件?

MCP 架构围绕 “模型控制、交互适配、监控运维” 设计,核心组件包括 5 个部分:

协议解析器(Protocol Parser):负责解析客户端发送的 MCP 协议请求(如 JSON 格式),验证请求格式合法性(如参数是否完整、类型是否正确),将请求转换为大模型可识别的内部格式;同时将大模型的返回结果按 MCP 规范封装,返回给客户端。

模型适配器(Model Adapter):作为 MCP 与大模型的中间层,适配不同大模型的原生接口(如 OpenAI API、Hugging Face Transformers 接口),实现 “MCP 规范→模型原生接口” 的转换 —— 例如将 MCP 的 “temperature” 参数映射为 GPT 的 “temperature” 或 Llama 的 “top_p” 参数,屏蔽模型接口差异。

生成控制器(Generation Controller):实现对大模型生成过程的精细化控制,支持动态调整生成参数(如中途修改 max_tokens)、中断生成(如检测到违规内容时停止)、设置生成规则(如停止词、格式约束),确保生成结果符合业务需求。

工具调度器(Tool Scheduler):管理大模型调用的外部工具(如检索工具、API 服务),按 MCP 规范解析工具调用请求,调度对应工具执行,将工具返回结果按格式整理后传递给大模型,支持工具调用的重试、超时控制。

监控与日志组件(Monitoring & Logging Component):记录 MCP 协议交互的全链路日志(如请求参数、响应结果、调用耗时、Token 消耗),监控大模型调用成功率、延迟、错误码等指标,支持告警功能(如调用失败率超过阈值时触发告警),便于系统运维与问题排查。

21.MCP 协议支持哪两种模式?

MCP 协议主要支持 “同步调用模式” 与 “异步调用模式” 两种,适配不同场景对响应时间与资源占用的需求:

同步调用模式(Synchronous Call Mode):客户端发送 MCP 请求后,阻塞等待大模型返回结果,直至生成完成或超时。核心特点:① 实时性高:结果返回及时,适合对响应时间敏感的场景(如实时对话、即时检索);② 资源占用集中:客户端需持续保持连接,大模型生成耗时较长时(如生成万字报告),会占用客户端与服务器连接资源。适用场景:短文本生成(如客服对话、单轮问答)、工具调用(如实时检索)。

异步调用模式(Asynchronous Call Mode):客户端发送 MCP 请求后,服务器立即返回 “请求 ID”,不阻塞客户端;大模型在后台异步执行生成任务,完成后将结果存入指定存储(如数据库、消息队列);客户端通过 “请求 ID” 轮询或监听回调接口获取结果。核心特点:① 非阻塞:客户端无需等待,可处理其他任务,降低资源占用;② 支持长耗时任务:适合大模型生成耗时较长的场景(如生成长篇报告、多轮工具调用);③ 实时性低:结果获取存在延迟,需额外处理轮询或回调逻辑。适用场景:长文本生成(如行业报告、代码生成)、批量处理(如批量问答生成)。

22.MCP 与 Function Calling 的区别是什么?

23.MCP 的工作流程是什么?

以 “大模型调用检索工具生成回答” 为例,MCP 协议的工作流程(同步调用模式)如下:

客户端发起请求:客户端按 MCP 规范构建请求(JSON 格式),包含 “模型 ID(如 gpt-4)、任务类型(工具调用 + 生成)、检索工具参数(如查询关键词 “2024 销量”)、生成参数(temperature=0.3)”,发送给 MCP 服务器。

协议解析与验证:MCP 协议解析器接收请求,验证格式合法性(如参数是否缺失、类型是否正确),若不合法返回错误码(如 “参数缺失:检索关键词未提供”);若合法,将请求转换为内部格式。

模型与工具适配:模型适配器将 MCP 请求转换为目标大模型的原生接口格式,工具调度器按 MCP 规范调用检索工具,传入查询关键词,获取检索结果(如 5 个相关文档片段)。

生成控制与执行:生成控制器将检索结果与用户查询整合为提示词,传递给大模型,同时按 MCP 请求中的参数(temperature=0.3)控制生成过程,确保不超出 max_tokens 限制。

结果封装与返回:大模型生成回答后,MCP 服务器按 MCP 规范封装结果(包含 “回答文本、检索来源、调用耗时、Token 消耗”),返回给客户端。

监控与日志:监控组件记录本次调用的全链路日志(请求参数、响应结果、错误码)

24. 在 Spring AI 框架中如何集成 MCP?

Spring AI 是 Spring 生态中用于简化大模型应用开发的框架,集成 MCP 需通过 “自定义组件适配 MCP 协议”,核心步骤如下:

引入 MCP 客户端依赖:在项目 pom.xml 中添加 MCP 客户端 SDK 依赖(如 MCP 官方提供的 Java SDK,或自定义 HTTP 客户端依赖),用于发送 MCP 协议请求。

配置 MCP 服务器信息:在 application.yml 中配置 MCP 服务器地址、认证信息(如 API Key)、超时时间等,示例:

yaml

spring:

ai:

mcp:

server-url: http://localhost:8080/mcp/api

api-key: your-mcp-api-key

connect-timeout: 5000

read-timeout: 30000自定义 MCP 客户端组件:创建 McpClient 类,封装 MCP 协议请求的构建、发送与响应解析逻辑 ——① 按 MCP 规范构建 JSON 格式请求(包含模型 ID、任务类型、参数等);② 用 RestTemplate 或 OkHttp 发送 HTTP 请求到 MCP 服务器;③ 解析 MCP 响应,转换为 Spring AI 可识别的 GenerationResponse 格式。

java

@Service

public class McpClient {

@Value("${spring.ai.mcp.server-url}")

private String serverUrl;

@Value("${spring.ai.mcp.api-key}")

private String apiKey;

public GenerationResponse generate(McpRequest request) {

// 1. 构建 MCP 协议请求(JSON 格式)

Map<String, Object> mcpRequestMap = new HashMap<>();

mcpRequestMap.put("modelId", request.getModelId());

mcpRequestMap.put("taskType", "TEXT_GENERATION");

mcpRequestMap.put("parameters", request.getParameters());

mcpRequestMap.put("apiKey", apiKey);

// 2. 发送请求到 MCP 服务器

RestTemplate restTemplate = new RestTemplate();

ResponseEntity<Map> response = restTemplate.postForEntity(

serverUrl + "/generate",

mcpRequestMap,

Map.class

);

// 3. 解析响应,转换为 Spring AI GenerationResponse

Map<String, Object> responseBody = response.getBody();

String generatedText = (String) responseBody.get("result");

return new GenerationResponse(new Generation(generatedText));

}

}集成 Spring AI 生成器:创建 McpTextGenerator 类,实现 Spring AI 的 TextGenerator 接口,内部调用 McpClient 发送 MCP 请求,示例:

java

@Component

public class McpTextGenerator implements TextGenerator {

private final McpClient mcpClient;

@Autowired

public McpTextGenerator(McpClient mcpClient) {

this.mcpClient = mcpClient;

}

@Override

public GenerationResponse generate(Prompt prompt) {

// 构建 MCP 请求(设置模型 ID、生成参数、提示词)

McpRequest request = new McpRequest();

request.setModelId("gpt-4");

request.setParameters(Map.of("temperature", 0.3, "prompt", prompt.getContents().get(0).getText()));

// 调用 MCP 客户端生成回答

return mcpClient.generate(request);

}

}业务层调用:在 Service 或 Controller 中注入 McpTextGenerator,直接调用 generate 方法生成内容,示例:

java

@Service

public class AiService {

@Autowired

private McpTextGenerator textGenerator;

public String generateAnswer(String question) {

Prompt prompt = new Prompt(question);

GenerationResponse response = textGenerator.generate(prompt);

return response.getGenerations().get(0).getText();

}

}25.MCP 协议安全性设计包含哪些层面?

MCP 协议的安全性设计围绕 “身份认证、数据传输、权限控制、内容安全、审计追溯” 五个核心层面,确保大模型交互过程中的数据安全与合规:

身份认证与授权:① 基于 API Key 或 Token 认证:客户端发送 MCP 请求时需携带唯一认证信息(如 API Key),MCP 服务器验证认证信息合法性,拒绝未授权请求;② 细粒度权限控制:按 “用户 / 角色” 分配权限(如普通用户仅能调用特定模型,管理员可调用所有模型 + 工具),避免越权操作。

数据传输安全:① 加密传输:采用 HTTPS/TLS 协议加密 MCP 请求与响应,防止数据在传输过程中被窃取或篡改;② 敏感数据脱敏:对请求中的敏感信息(如用户手机号、身份证号)进行脱敏处理(如替换为 “**”),仅传输必要非敏感数据。

内容安全过滤:① 输入过滤:MCP 服务器对客户端发送的提示词、工具参数进行合规性检测(如关键词匹配、语义分析),拦截含违规内容(如暴力、歧视、违法信息)的请求;② 输出审核:对大模型生成的回答进行内容审核,过滤违规输出,确保返回结果符合业务规范与法律法规。

请求防滥用:① 流量控制:限制单个客户端的 MCP 请求频率(如每秒最多 10 次请求)、每日调用总量,避免恶意请求导致服务器过载;② 超时与重试限制:设置请求超时时间(如 30 秒),限制重试次数(如最多 3 次),防止无效请求占用资源。

审计与追溯:① 全链路日志记录:记录每一次 MCP 调用的 “请求参数、响应结果、调用时间、调用者身份、错误信息”,日志长期留存用于审计;② 操作追溯:若出现安全事件(如违规内容生成),可通过日志追溯到具体调用者、时间与请求内容,便于责任定位。

26. 如何将已有的应用转换成 MCP 服务?

将已有应用(如大模型调用工具、自定义推理服务)转换为 MCP 服务,核心是 “按 MCP 协议规范封装应用接口”,让应用支持 MCP 协议的请求接收、解析与响应,具体步骤如下:

分析应用核心能力:明确已有应用的核心功能(如 “文本生成”“工具调用”“向量检索”)、输入参数(如模型 ID、提示词、工具参数)、输出格式(如生成文本、检索结果),确定 MCP 协议中对应的 “任务类型”(如 TEXT_GENERATION、TOOL_CALL)。

定义 MCP 接口映射:将应用的原生接口参数与 MCP 协议参数进行映射,例如:应用原生参数 “model_name” 映射为 MCP 的 “modelId”,“prompt_text” 映射为 MCP 的 “parameters.prompt”,确保 MCP 请求能正确转换为应用可识别的参数。

开发 MCP 协议适配层:在已有应用中新增 MCP 适配模块,实现 “MCP 请求→应用原生请求” 的转换与 “应用原生响应→MCP 响应” 的封装:① 请求解析:接收客户端发送的 MCP 请求(如 JSON 格式),验证参数完整性,按映射关系转换为应用原生参数;② 响应封装:执行应用核心逻辑后,将原生响应(如生成的文本、工具结果)按 MCP 规范整理为响应格式(包含结果、耗时、状态码)。

集成 MCP 服务组件:引入 MCP 服务端基础组件(如协议解析器、监控日志模块),支持:① MCP 协议格式验证(如检查请求是否符合 MCP 规范);② 身份认证(如验证客户端 API Key);③ 日志记录与监控(如记录调用日志、暴露监控指标)。

部署与测试:① 部署转换后的 MCP 服务,对外提供 MCP 协议接口(如 HTTP 接口 /mcp/api/generate);② 编写 MCP 客户端测试用例,发送 MCP 请求验证服务功能(如调用文本生成接口,检查响应是否符合 MCP 规范);③ 优化性能:若服务并发量高,可添加负载均衡、缓存机制,确保 MCP 服务稳定运行。

示例:若已有应用是 “自定义文本生成服务”,转换后需支持 MCP 的 TEXT_GENERATION 任务类型,接收 MCP 请求中的 “modelId”“parameters.prompt”,返回 MCP 格式的 “result”(生成文本)与 “costTime”(调用耗时)。

27. 什么是大模型微调?与预训练的核心区别是什么?

大模型微调(Fine-Tuning):是在大模型 “预训练完成后”,使用特定领域 / 任务的小批量数据(如医疗领域文档、企业内部数据),继续训练模型参数(或部分参数),让模型适配特定场景需求的过程。核心目标是 “在预训练模型基础上,优化模型在特定任务上的性能(如医疗问答准确性、企业文档检索相关性)”,无需从零开始训练。

与预训练(Pre-Training)的核心区别:

28. 常见的微调任务有哪些?

大模型微调任务按 “应用场景” 可分为以下 6 类,每类任务对应特定的模型优化目标:

文本分类任务:让模型将文本归类到预设类别,如 “情感分析(正面 / 负面 / 中性)”“垃圾邮件检测(垃圾 / 非垃圾)”“新闻分类(体育 / 财经 / 科技)”。微调数据通常为 “文本 + 类别标签”,目标是提升模型分类准确率。

序列标注任务:让模型为文本中的每个 token(词 / 字)标注特定标签,如 “命名实体识别(标注人名、地名、机构名)”“词性标注(标注名词、动词、形容词)”“关键词提取(标注文本核心词)”。微调数据为 “文本 + token 级标签”,目标是提升模型对文本细节的识别能力。

问答任务:让模型根据给定上下文回答问题,分为 “抽取式问答(从上下文提取答案,如 SQuAD 数据集)” 与 “生成式问答(生成自然语言答案,如医疗领域 “症状→病因” 问答)”。微调数据为 “上下文 + 问题 + 答案”,目标是提升模型的信息检索与精准回答能力。

文本生成任务:让模型生成符合特定格式 / 风格的文本,如 “摘要生成(长文本→短摘要)”“翻译(中文→英文)”“代码生成(需求描述→代码片段)”“对话生成(用户输入→对话回复)”。微调数据为 “输入文本 + 目标生成文本”,目标是优化模型生成内容的相关性与格式准确性。

检索与匹配任务:让模型计算文本间的相似度或相关性,如 “文本相似度匹配(判断两个句子是否语义相似)”“检索排序(为查询匹配最相关的文档并排序)”。微调数据为 “文本对 + 相似度分数 / 标签”,目标是提升模型的语义匹配能力,适配 RAG 等场景。

多模态任务:针对多模态大模型(如 GPT-4V、Gemini),微调任务包括 “图文生成(图片→文本描述)”“图文问答(图片 + 问题→答案)”“跨模态检索(文本→相似图片)”。微调数据为 “多模态数据 + 标签”(如图片 + 描述文本、图片 + 问题 + 答案),目标是提升模型对多模态信息的理解与生成能力。

29. 常见的微调方法有哪些?

根据 “参数更新范围”“训练方式” 的不同,大模型微调方法可分为以下 5 类,各有适用场景与成本差异:

全参数微调(Full Parameter Fine-Tuning):更新预训练模型的所有参数,让模型完全适配目标任务。优势:微调效果最佳,模型对任务的适配性最强;缺点:训练成本极高(需大量 GPU 显存与算力,如 7B 模型全参数微调需 16GB+ GPU 显存),仅适合数据量充足(数万 - 数百万条)、预算高的场景(如企业定制专属大模型)。

冻结预训练层微调(Frozen Pre-Training Layers):冻结预训练模型的底层(如 Transformer 编码器前 10 层),仅更新顶层(如分类头、生成头)或少量上层参数。优势:训练参数少,成本低(显存占用仅为全参数微调的 1/5-1/3);缺点:适配能力有限,仅适合任务与预训练任务差异小的场景(如在通用文本分类基础上微调领域分类任务)。

LoRA(Low-Rank Adaptation,低秩适配):在预训练模型的 Transformer 层中插入低秩矩阵(如 7B 模型插入秩为 8 的矩阵),仅更新低秩矩阵参数,不修改预训练参数。优势:参数更新量极少(仅为全参数微调的 0.1%-1%),训练成本极低(7B 模型 LoRA 微调仅需 4GB+ GPU 显存),且微调效果接近全参数微调;缺点:需模型支持 LoRA 结构,适合中小规模数据(数千 - 数万条)、低成本场景(如个人开发者、中小企业微调)。

Adapter 微调:在预训练模型的 Transformer 层中插入小型 Adapter 模块(如 bottleneck 结构,先降维再升维),仅更新 Adapter 模块参数,预训练参数冻结。优势:参数更新量少(小于全参数微调的 5%),训练成本低,可灵活插入不同结构的 Adapter 适配任务;缺点:微调效果略逊于 LoRA,适合对模型结构有定制需求的场景(如多任务微调)。

提示微调(Prompt Tuning):不更新预训练模型参数,仅在输入提示中添加 “任务相关提示模板”(如分类任务添加 “这是一个 [类别] 文本:[输入文本]”),或训练小型 “提示嵌入层”(Prompt Embedding),让模型通过提示理解任务。优势:训练成本极低(几乎不占用额外显存),可实现多任务共享预训练模型;缺点:仅适合数据量极少(数百 - 数千条)的场景,微调效果依赖提示模板设计,对复杂任务适配性。